Les réseaux sociaux nous manipulent et déchirent notre tissu social. Le constat édifiant de Toxic Data, une analyse de l’influence de Twitter ou Facebook sur les opinions.

David Chavalarias est normalien, agrégé de mathématiques, docteur de l’École polytechnique, HDR de l’EHESS. Son livre Toxic Data, qui vient de sortir en format poche (Champs actuel), est, de l’avis du Lyonnais Cédric Villani – médaille Fields, plus prestigieuse récompense mondiale pour la reconnaissance de travaux en mathématiques –, à découvrir absolument. “Tous les citoyens devraient lire cet essai qui explique, mieux qu’aucun autre, pourquoi les ‘Big Tech’ menacent la démocratie – et comment leur résister.”

Lyon Capitale : Overdose numérique, intoxication numérique, dérèglement numérique… Si, comme vous le dites, les outils numériques ont représenté une innovation majeure dans la production et la diffusion des savoirs, ils ont aussi leurs côtés obscurs. Quels sont ceux de la force numérique ?

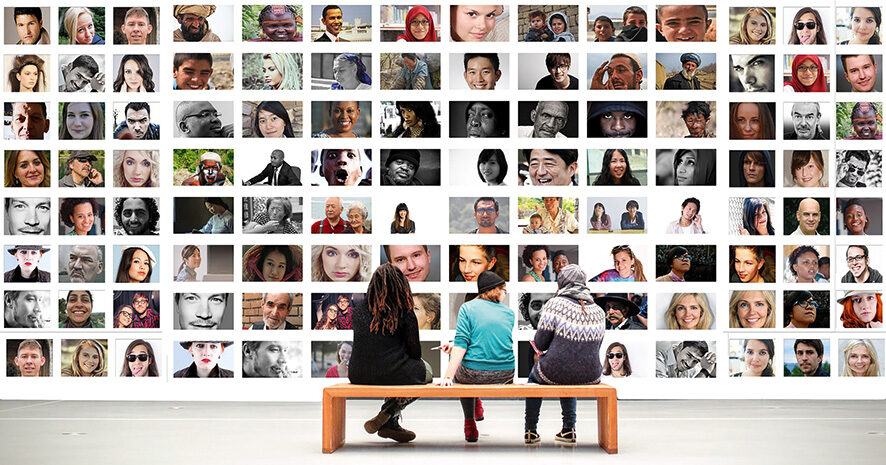

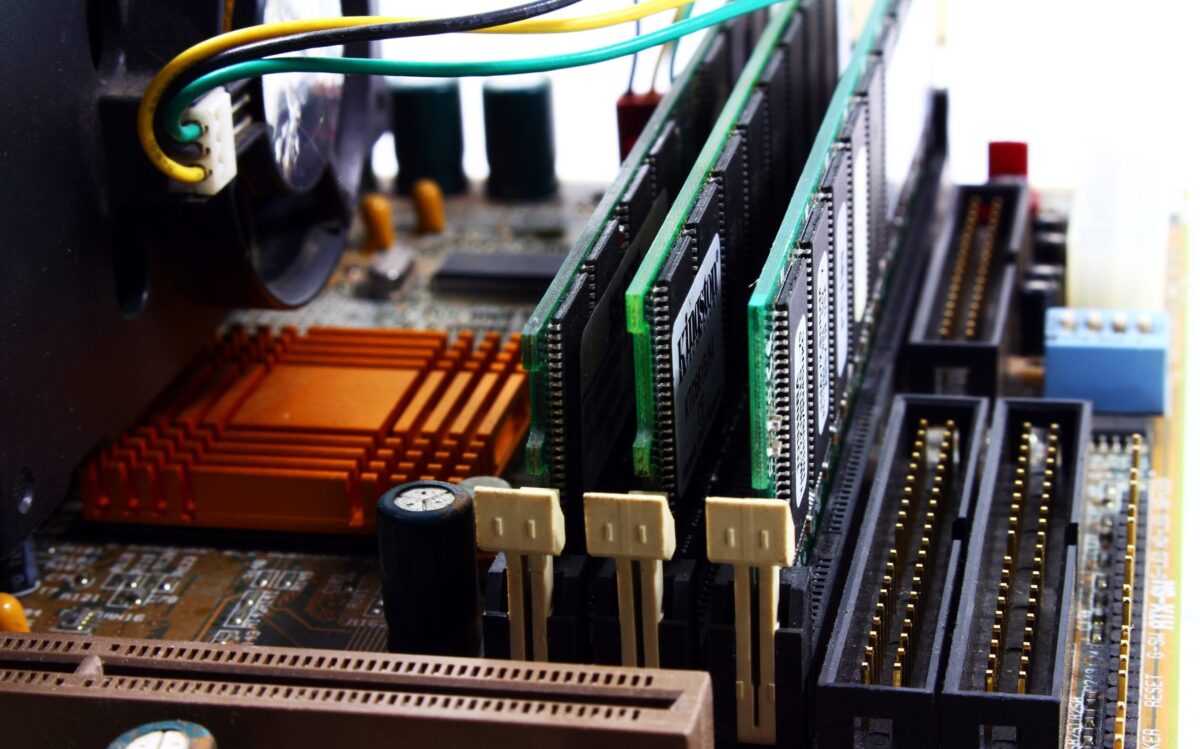

David Chavalarias : L’un des côtés obscurs de la force numérique est la manière dont on a déployé tout un pan de nos activités sociales dans des environnements numériques contrôlés par les Gafam [Google, Apple, Facebook, Amazon, Microsoft, NdlR]. Et notamment les réseaux sociaux qui sont des environnements avec des objectifs fondamentaux qui ne sont pas nécessairement ceux qui sont affichés : par exemple, Facebook dit “accomplir une mission sociale – rendre le monde plus ouvert et plus connecté”, alors qu’en réalité, il veut vendre de la publicité. Dans ces environnements numériques, on a tendance à oublier qu’on est toujours chez quelqu’un et qu’on a laissé nos données à la personne qui gère ces plateformes. On a également tendance à oublier que les échanges sociaux s’effectuent dans des conditions très différentes de la vie hors-ligne. Ils sont médiatisés par les plateformes numériques qui décident en fonction de leurs objectifs qui peut voir quoi, et donc, en creux, qui est visible et dans quelle mesure.

Ce n’est pas tant le numérique en lui-même qui est mauvais…

Tout à fait, c’est plutôt l’extrême concentration de son déploiement. Il faut se l’imaginer, Facebook, c’est quand même 2,8 milliards d’utilisateurs soumis peu ou prou aux mêmes algorithmes de recommandation. Cette utilisation à très, très grande échelle du numérique pour réaliser des objectifs qui ne sont pas nécessairement alignés avec le bien-être des utilisateurs crée ce premier côté obscur. Le deuxième côté obscur, forcément, c’est qu’en priorisant la rentabilité, les plateformes rendent leur communauté d’utilisateurs vulnérable à des manipulations d’opinion. Ces nouveaux environnements sont instrumentalisés en dehors de leur objectif initial qui est commercial.

“Dans ces environnements numériques, on a tendance à oublier qu’on est toujours chez quelqu’un et qu’on a laissé nos données à la personne qui gère ces plateformes”

Par quels mécanismes les environnements numériques sont-ils devenus toxiques pour nos relations ?

Il faut bien comprendre que ces environnements numériques sont des mondes très différents des environnements physiques. Par exemple, il n’y a plus de contrainte spatiale, plus de géographie ; on peut avoir des interactions avec autant de personnes que l’on veut, les messages peuvent être dupliqués à l’infini, etc. Surtout, pour gérer la surcharge d’information ainsi engendrée, les plateformes déploient une surcouche numérique qui va faire le tri : les algorithmes de recommandation. Je décris dans le détail les impacts de ce déploiement dans Toxic Data mais, pour ne mentionner qu’un exemple, il faut bien comprendre que sur des plateformes telles que Facebook, Twitter ou TikTok, vous ne voyez qu’une toute petite partie de ce que votre environnement social produit, mettons 10 %, et en général depuis votre fil d’actualité. Le problème est que la composition de votre fil d’actualité est le résultat d’une optimisation algorithmique qui vise à maximiser votre engagement, c’est-à-dire le nombre de partages, commentaires, likes, etc. Là où il y a interférence avec les biais cognitifs, c’est que les contenus qui maximisent notre engagement ne sont pas nécessairement ceux qui nous sont le plus bénéfiques, et la présence de contenus toxiques dans nos environnements numériques peut être ainsi artificiellement amplifiée.

C’est à ce moment qu’intervient le côté sciences cognitives ?

Effectivement. Lorsqu’on est face à différents types d’information, on va réagir de façon préférentielle avec des informations qui comportent une certaine dose d’anxiété, de négativité ou de toxicité. C’est ce qu’on appelle le biais de négativité qui nous pousse à savoir ce qui est susceptible de nous menacer. Or, dans les environnements apprenants comme les réseaux sociaux, les algorithmes de recommandation vont apprendre que c’est ce genre de contenus qui sont susceptibles de nous faire réagir. Ils vont donc nous en resservir ad nauseam même s’ils ne représentent qu’une petite partie de la production de nos amis. C’est là qu’une distorsion se produit dans le sens où ce qu’on perçoit dans l’environnement social numérique n’est pas le reflet de la réalité.

L’entre-soi est-il plus favorisé que dans la vie réelle ?

Dans certains cas oui parce qu’à partir du moment où l’information est organisée en fonction de ce que l’on sait sur vous, il y a des dérives qui peuvent mener à la formation d’entre-soi très forts – ce qu’on appelle les chambres d’écho ou les bulles de filtre. Cela crée un phénomène dans lequel des informations tournent en boucle au sein d’une communauté d’utilisateurs qui partagent plus ou moins les mêmes informations. Et quand une information extérieure vient contredire une communauté, elle va immédiatement être dénigrée ou faire l’objet d’une réaction vive. Ce qu’il faut bien voir, c’est que si on regarde d’en haut, en analysant un grand nombre d’échanges et la manière dont ils se structurent, on remarque que ces échanges d’information sont architecturés sous forme de bulles informationnelles à l’intérieur desquelles on a un ensemble d’utilisateurs qui partagent, grosso modo, les mêmes informations et sont alignés idéologiquement, se confortant ainsi dans leurs croyances. Dans le cas de débats sociétaux clivants, les échanges entre membres de deux bulles informationnelles deviennent alors plus facilement conflictuels du fait qu’ils ne partagent plus la même réalité. Il y a donc un affaiblissement voire un déchirement du tissu social sous l’effet même des algorithmes de recommandation.

Il vous reste 62 % de l'article à lire.

Article réservé à nos abonnés.